Openai diz que Deepseek copiou o chatgpt, mas está enfrentando alegações de direitos autorais também

Até algumas semanas atrás, poucas pessoas no mundo ocidental haviam ouvido falar de uma pequena empresa de inteligência artificial chinesa (IA) conhecida como Deepseek. Mas em 20 de janeiro, é capturou atenção global Quando lançou um novo modelo de IA chamado R1.

O R1 é um modelo de “raciocínio”, o que significa que funciona através de tarefas passo a passo e detalha seu processo de trabalho para um usuário. É uma versão mais avançada do Deepseek's Modelo v3que foi lançado em dezembro. A nova oferta da Deepseek é quase tão poderosa quanto a empresa mais avançada da empresa rival OpenAI, o modelo O1, mas por uma fração do custo.

Em poucos dias, o aplicativo da Deepseek superou o ChatGPT em novos downloads e estabeleceu preços de ações das empresas de tecnologia nos Estados Unidos caindo. Também levou o OpenAi para alegar que seu rival chinês havia efetivamente roubado algumas das jóias da coroa dos modelos da Openai para construir a sua.

Em um Declaração para o New York Timesa empresa disse:

Estamos cientes e analisando indicações de que a Deepseek pode ter destilado de maneira inadequada nossos modelos e compartilharemos informações como sabemos mais. Tomamos contramedidas agressivas e proativas para proteger nossa tecnologia e continuaremos trabalhando em estreita colaboração com o governo dos EUA para proteger os modelos mais capazes que estão sendo construídos aqui.

A conversa se aproximou do Deepseek para comentar, mas não respondeu.

Mas mesmo que Deepseek copiasse – ou, na linguagem científica, “destilada” – pelo menos alguns do chatgpt para construir R1, vale lembrar que o Openai também é acusado de desrespeitar a propriedade intelectual enquanto desenvolve seus modelos.

O que é destilação?

A destilação do modelo é uma técnica comum de aprendizado de máquina, na qual um “modelo de aluno” menor é treinado em previsões de um “modelo de professor” maior e mais complexo.

Quando concluído, o aluno pode ser quase tão bom quanto o professor, mas representará o conhecimento do professor de maneira mais eficaz e compacta.

Para fazer isso, não é necessário acessar o funcionamento interno do professor. Tudo o que é preciso fazer esse truque é fazer ao professor modelo de perguntas suficientes para treinar o aluno.

Foi o que o OpenAI afirma que a Deepseek fez: consultou o Open's O1 em uma escala enorme e usou as saídas observadas para treinar modelos mais eficientes de Deepseek.

Uma fração dos recursos

Deepseek reivindicações O fato de o treinamento e o uso do R1 exigiram apenas uma fração dos recursos necessários para desenvolver os melhores modelos de seus concorrentes.

Há razões para ser cético em relação a alguns dos hype de marketing da empresa – por exemplo, um Novo relatório independente Sugere que o gasto de hardware em R1 foi tão alto quanto US $ 500 milhões. Mas, mesmo assim, o Deepseek ainda foi construído de maneira muito rápida e eficiente em comparação com os modelos rivais.

Isso pode ser porque o Deepseek destilou a saída do OpenAI. No entanto, atualmente não existe um método para provar isso conclusivamente. Um método que está nos estágios iniciais do desenvolvimento é Saídas de IA da marca d'água. Isso adiciona padrões invisíveis às saídas, semelhantes às aplicadas a imagens protegidas por direitos autorais. Existem várias maneiras de fazer isso em teoria, mas nenhuma é eficaz ou eficiente o suficiente para ter entrado em prática.

Existem outras razões que ajudam a explicar o sucesso da Deepseek, como o trabalho técnico profundo e desafiador da empresa.

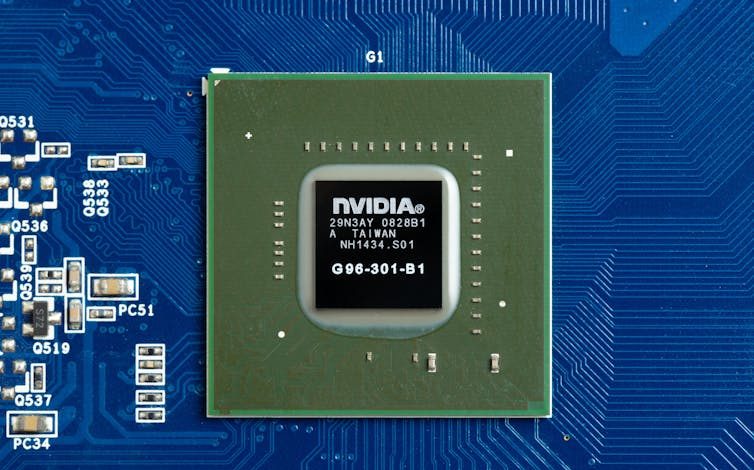

Os avanços técnicos feitos pela Deepseek incluíram aproveitar os chips AI menos poderosos, mas mais baratos (também chamados de unidades de processamento gráfico ou GPUs).

Deepseek não teve escolha a não ser se adaptar depois do Nós proibiu empresas da exportação dos chips de IA mais poderosos para a China.

Enquanto as empresas ocidentais de IA podem comprar essas unidades poderosas, a proibição de exportação forçou as empresas chinesas a inovar para fazer o melhor uso de alternativas mais baratas.

Uma série de ações judiciais

Openai's termos de uso declarar explicitamente que ninguém pode usar seus modelos de IA para desenvolver produtos concorrentes. No entanto, seus próprios modelos são treinados em conjuntos de dados maciços raspados na web. Esses conjuntos de dados contidos uma quantidade substancial de material protegido por direitos autoraisque o Openai diz que tem o direito de usar com base em “uso justo”:

O treinamento de modelos de IA usando materiais de Internet disponível ao público é o uso justo, conforme suportado por precedentes de longa data e amplamente aceitos. Vemos esse princípio justo para os criadores, necessário para os inovadores e crítico para a competitividade dos EUA.

Este argumento será testado no tribunal. JornaisAssim, músicosAssim, autores E outros criativos entraram com uma série de ações contra o OpenAI com base na violação de direitos autorais.

Claro, isso é bastante distinto do que o Openai acusa Deepseek de fazer. No entanto, Openai não está atraindo muita simpatia por sua alegação de que a DeepSeek colheu ilegitimamente sua produção de modelo.

A guerra de palavras e ações judiciais é um artefato de como o rápido avanço da IA superou o desenvolvimento de regras legais claras para o setor. E embora esses eventos recentes possam reduzir o poder dos titulares de IA, muitas depende do resultado das várias disputas legais em andamento.

Agitando a conversa global

A Deepseek mostrou que é possível desenvolver modelos de ponta de ponta de maneira barata e eficiente. Ainda não se sabe se eles podem competir com o OpenAI em um campo de jogo.

No fim de semana, o Openai tentou demonstrar sua supremacia por liberação publicamente Seu modelo de consumidor mais avançado, O3-mini.

O OpenAI afirma que esse modelo supera substancialmente sua própria versão anterior de mercado, O1, e é o “modelo mais econômico em nossa série de raciocínio”.

Esses desenvolvimentos anunciam uma era de maior escolha para os consumidores, com uma diversidade de modelos de IA no mercado. Esta é uma boa notícia para os usuários: as pressões competitivas tornarão os modelos mais baratos de usar.

E os benefícios se estendem mais adiante.

Treinar e usar esses modelos coloca um tensão maciça no consumo de energia global. À medida que esses modelos se tornam mais onipresentes, todos nos beneficiamos de melhorias para sua eficiência.

A ascensão de Deepseek certamente marca um novo território para construir modelos de maneira mais barata e eficiente. Talvez isso também abrite a conversa global sobre como as empresas de IA devem coletar e usar seus dados de treinamento.![]()

(Autor: Lea FrermannProfessor Sênior de Processamento de Linguagem Natural, Universidade de Melbourne, A Universidade de Melbourne e Shananan CohneyProfessor de segurança cibernética, A Universidade de Melbourne)

Este artigo é republicado de A conversa sob uma licença Creative Commons. Leia o Artigo original.

(Exceto pela manchete, esta história não foi editada pela equipe da NDTV e é publicada em um feed sindicalizado.)