Por que o DeepSeek é tão dividido? Os cientistas explicam como os modelos de IA funcionam e por que eram tão baratos de construir.

Menos de duas semanas atrás, uma empresa chinesa mal conhecida divulgou seu último inteligência artificial (AI) Modelo e enviou ondas de choque em todo o mundo.

Deepseek afirmou em um papel técnico enviado para Girub que seu modelo R1 de peso aberto alcançado resultados comparáveis ou melhores do que os modelos de IA fabricados por alguns dos principais gigantes do Vale do Silício – o chatgpt de Openai, a lhama de Meta e Claude do Anthropic. E o mais impressionante, o modelo alcançou esses resultados enquanto foi treinado e executado por uma fração do custo.

A resposta do mercado às notícias na segunda -feira foi nítida e brutal: quando a Deepseek se tornou para se tornar o mais baixado aplicativo grátis Na App Store da Apple, US $ 1 trilhão foram varridos das avaliações das principais empresas de tecnologia dos EUA.

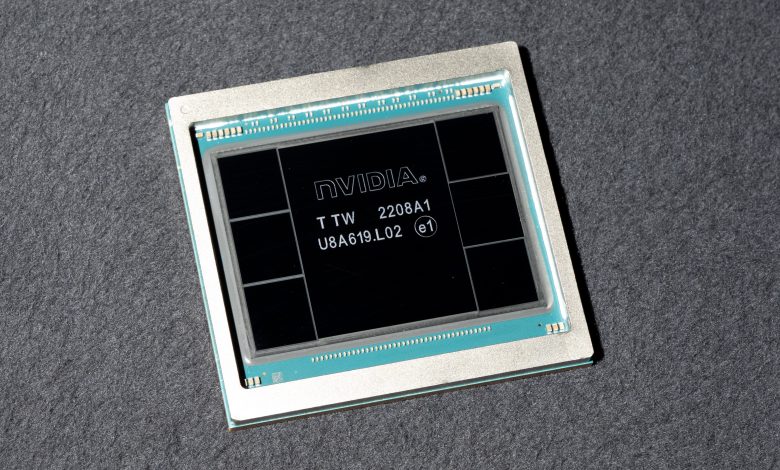

E a Nvidia, uma empresa que torna os chips de gráficos H100 de ponta que se presumiu essencial para o treinamento de IA, perdeu US $ 589 bilhões em avaliação no maior perda de mercado de um dia na história dos EUA. Afinal, a DeepSeek disse que treinou seu modelo de IA sem eles-embora tenha usado chips Nvidia menos poderosos. As empresas de tecnologia dos EUA responderam com pânico e ira, com representantes do Openai mesmo sugerindo que Deepseek partes plagiadas de seus modelos.

Relacionado: AI agora pode se replicar – um marco que tem especialistas aterrorizados

Especialistas da IA dizem que o surgimento de Deepseek elevou um dogma -chave subjacente à abordagem da indústria para o crescimento – mostrando que maior nem sempre nem sempre é melhor.

“O fato de que a Deepseek poderá ser construída por menos dinheiro, menos computação e menos tempo e pode ser executada localmente em máquinas menos caras, argumenta que, à medida que todos estavam correndo para maior e maior, perdemos a oportunidade de construir mais inteligência e menor”. Kristian Hammond, Um professor de ciência da computação na Northwestern University, disse ao Live Science em um email.

Mas o que torna os modelos V3 e R1 de Deepseek tão perturbadores? A chave, dizem os cientistas, é a eficiência.

O que faz os modelos de Deepseek funcionarem?

“De certa forma, os avanços de Deepseek são mais evolutivos do que revolucionários”. Ambuj TewariProfessor de Estatística e Ciência da Computação da Universidade de Michigan, disse à Live Science. “Eles ainda estão operando sob o paradigma dominante de modelos muito grandes (100s de bilhões de parâmetros) em conjuntos de dados muito grandes (trilhões de tokens) com orçamentos muito grandes”.

Se aceitarmos as reivindicações de Deepseek pelo valor nominal, disse Tewari, a principal inovação para a abordagem da empresa é como ela exerce seus modelos grandes e poderosos para executar igualmente e outros sistemas enquanto usam menos recursos.

A chave para isso é um sistema de “mistura de especialistas” que divide os modelos da Deepseek em submodelos, cada um especializado em uma tarefa ou tipo de dados específico. Isso é acompanhado por um sistema de suporte de carga que, em vez de aplicar uma penalidade geral para retardar um sistema sobrecarregado, como outros modelos, muda dinamicamente as tarefas das submodelas sobrecarregadas para excesso de trabalho.

“[This] significa que, embora o modelo V3 tenha 671 bilhões de parâmetros, apenas 37 bilhões são realmente ativados para qualquer token “, disse Tewari. Um simplório refere -se a uma unidade de processamento em um grande modelo de idioma (LLM), equivalente a um pedaço de texto.

Aumentar esse balanceamento de carga é uma técnica conhecida como “escala de computação em tempo de inferência”, um mostrador nos modelos da Deepseek que rampas alocavam a computação para cima ou para baixo para corresponder à complexidade de uma tarefa atribuída.

Essa eficiência se estende ao treinamento dos modelos de Deepseek, que os especialistas citam como uma conseqüência não intencional das restrições de exportação dos EUA. ChinaO acesso aos chips H100 da NVIDIA é limitado, então a DeepSeek afirma que construiu seus modelos usando chips H800, que têm uma taxa de transferência de dados de chip-chip reduzida. A Nvidia projetou este chip “mais fraco” em 2023 especificamente para contornar os controles de exportação.

Um tipo mais eficiente de modelo de linguagem grande

A necessidade de usar esses chips menos poderosos forçou a Deepseek a fazer outro avanço significativo: sua estrutura de precisão mista. Em vez de representar todos os pesos de seu modelo (os números que definem a força da conexão entre os neurônios artificiais de um modelo de IA) usando números de ponto flutuante de 32 bits (FP32), ele treinou uma parte de seu modelo com 8 bits menos recompensados Números (FP8), alternando apenas para 32 bits para cálculos mais difíceis em que a precisão é importante.

“Isso permite treinamento mais rápido com menos recursos computacionais”. Thomas Caoum professor de política de tecnologia na Tufts University, disse ao Live Science. “A Deepseek também refinou quase todas as etapas de seu pipeline de treinamento – carregamento de dados, estratégias de paralelização e otimização de memória – para que ele alcance uma eficiência muito alta na prática”.

Da mesma forma, embora seja comum treinar modelos de IA usando rótulos fornecidos pelo homem para obter a precisão das respostas e raciocínio, o raciocínio de R1 não é supervisionado. Ele usa apenas a correção das respostas finais em tarefas como matemática e codificação para o seu sinal de recompensa, que liberta os recursos de treinamento para serem usados em outros lugares.

Tudo isso resulta em um par de modelos surpreendentemente eficientes. Enquanto os custos de treinamento dos concorrentes de Deepseek se deparam com o dezenas de milhões a centenas de milhões de dólares E geralmente leva vários meses, os representantes do Deepseek dizem que a empresa treinou V3 em dois meses por apenas US $ 5,58 milhões. Os custos de funcionamento do DeepSeek V3 são igualmente baixos – 21 vezes mais barato de correr do que Claude de 3,5 sonetos do Anthropic.

O CAO tem cuidado ao observar que a pesquisa e o desenvolvimento da Deepseek, que incluem seu hardware e um grande número de experimentos de avaliação e erro, significa que quase certamente gastou muito mais do que esse valor de US $ 5,58 milhões. No entanto, ainda é uma queda suficientemente significativa no custo de ter capturado seus concorrentes.

No geral, os especialistas da IA dizem que a popularidade de Deepseek é provavelmente um positivo líquido para a indústria, reduzindo os custos exorbitantes de recursos e diminuindo a barreira à entrada para pesquisadores e empresas. Também poderia criar espaço para mais fabricantes de chips do que a Nvidia entrar na corrida. No entanto, também vem com seus próprios perigos.

“Como métodos mais baratos e mais eficientes para o desenvolvimento de modelos de IA de ponta se tornam publicamente disponíveis, eles podem permitir que mais pesquisadores em todo o mundo busquem o desenvolvimento de LLM de ponta, potencialmente acelerando o progresso científico e a criação de aplicativos”, disse Cao. “Ao mesmo tempo, essa menor barreira à entrada levanta novos desafios regulatórios-além da rivalidade EUA-China-sobre o uso indevido ou os efeitos potencialmente desestabilizadores da IA avançada por atores estatais e não estatais”.