Computadores biológicos podem usar muito menos energia do que a tecnologia atual – trabalhando mais lentamente

Moderno computadores são um triunfo da tecnologia. Um único chip de computador contém bilhões de transistores com escala de nanomete que operam de maneira extremamente confiável e a uma taxa de milhões de operações por segundo.

No entanto, essa alta velocidade e confiabilidade têm o custo de consumo significativo de energia: data centers e utensílios domésticos de TI, como computadores e smartphones, representam em torno de 3% da demanda global de eletricidadee o uso de Ai é provável que dirija Ainda mais consumo.

Mas e se pudéssemos redesenhar a maneira como os computadores funcionam para que eles pudessem executar tarefas de computação tão rapidamente quanto hoje enquanto usavam muito menos energia? Aqui, a natureza pode nos oferecer algumas soluções em potencial.

O cientista da IBM, Rolf Landauer em 1961. Ele criou o limite de Landauer, que afirma que uma única tarefa computacional – por exemplo, definindo um pouco, a menor unidade de informação do computador, para ter um valor de zero ou um – deve gastar cerca de 10⁻²tes joules (j) de energia .

Relacionado: História dos computadores: uma breve linha do tempo

Essa é uma quantidade muito pequena, apesar dos muitos bilhões de tarefas que os computadores executam. Se pudéssemos operar computadores nesses níveis, a quantidade de eletricidade usada na computação e o gerenciamento de calor residual com sistemas de refrigeração não se preocuparia.

No entanto, há um problema. Para realizar uma operação de um pouco perto do limite de Landauer, ele precisa ser realizado infinitamente lentamente. Prevê -se que a computação em qualquer período finito custe um valor adicional proporcional à taxa na qual os cálculos são realizados. Em outras palavras, quanto mais rápido o cálculo, mais energia é usada.

Mais recentemente isso tem sido demonstrado por experimentos Configurado para simular processos computacionais: a dissipação de energia começa a aumentar de maneira mensurável quando você realiza mais de uma operação por segundo. Os processadores que operam a uma velocidade de relógio de um bilhão de ciclos por segundo, o que é típico nos semicondutores atuais, usam cerca de 10⁻vio por bit – cerca de dez bilhões de vezes mais que o limite de Landauer.

Uma solução pode ser projetar computadores de uma maneira fundamentalmente diferente. A razão pela qual os computadores tradicionais funcionam a um ritmo muito rápido é que eles operam em série, uma operação por vez. Se, em vez disso, pudesse usar um número muito grande de “computadores” que trabalham em paralelo, cada um poderia funcionar muito mais lento.

Por exemplo, pode -se substituir um processador “lebre” que executa um bilhão de operações em um segundo por um bilhão de processadores de “tartaruga”, cada um tomando um segundo completo para realizar sua tarefa, a um custo de energia muito menor por operação. Um artigo de 2023 que eu co-autorizei mostrou que um computador poderia então operar perto do limite de Landauerusando ordens de magnitude menos energia do que os computadores atuais.

Poder de tartaruga

É possível ter bilhões de “computadores” independentes trabalhando em paralelo? O processamento paralelo em uma escala menor é comumente usado hoje, por exemplo, quando cerca de 10.000 unidades de processamento de gráficos ou GPUs são executadas ao mesmo tempo para treinar modelos de inteligência artificial.

No entanto, isso não é feito para reduzir a velocidade e aumentar a eficiência energética, mas por necessidade. Os limites do gerenciamento de calor tornam impossível aumentar ainda mais o poder de computação de um único processador; portanto, os processadores são usados em paralelo.

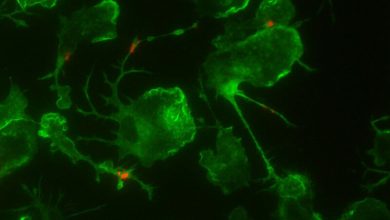

Um sistema de computação alternativo que está muito mais próximo do que seria necessário para abordar o limite de Landauer é conhecido como biocomputação baseada em rede. Faz uso de proteínas motoras biológicas, que são pequenas máquinas que ajudam a executar tarefas mecânicas dentro das células.

Este sistema envolve codificar uma tarefa computacional em um labirinto nanofabricado de canais com interseções cuidadosamente projetadas, que normalmente são feitas de padrões de polímero depositados em bolachas de silício. Todos os caminhos possíveis através do labirinto são explorados em paralelo por um número muito grande de moléculas longas semelhantes a roscas chamadas biofilamentos, que são alimentados pelas proteínas motoras.

Cada filamento tem apenas alguns nanômetros de diâmetro e cerca de um micrômetros de comprimento (1.000 nanômetros). Cada um deles atua como um “computador” individual, codificando informações por sua posição espacial no labirinto.

Essa arquitetura é particularmente adequada para resolver os chamados problemas combinatórios. Esses são problemas com muitas soluções possíveis, como tarefas de agendamento, que são computacionalmente muito exigentes para computadores em série. Experimentos confirmam que esse biocomputador requer entre 1.000 e 10.000 vezes menos energia por computação do que um processador eletrônico.

Isso é possível porque as proteínas motoras biológicas evoluíram para não usar mais energia do que o necessário para executar sua tarefa na taxa necessária. Normalmente, são algumas centenas de etapas por segundo, um milhão de vezes mais lento que os transistores.

Atualmente, Apenas pequenos computadores biológicos foram construídos por pesquisadores para provar o conceito. Para ser competitivo com computadores eletrônicos em termos de velocidade e computação, e explorar um grande número de soluções possíveis em paralelo, a biocomputação baseada em rede precisa ser ampliada.

Uma análise detalhada mostra que isso deve ser possível com a tecnologia atual de semicondutores e poderia lucrar com outra grande vantagem das biomoléculas sobre os elétrons, a saber, sua capacidade de transportar informações individuais, por exemplo, na forma de uma etiqueta de DNA.

No entanto, existem numerosos obstáculos para escalar essas máquinas, incluindo o aprendizado de controlar com precisão cada um dos biofilamentos, reduzir suas taxas de erro e integrá -las à tecnologia atual. Se esses tipos de desafios puderem ser superados nos próximos anos, os processadores resultantes poderão resolver certos tipos de problemas computacionais desafiadores com um custo de energia massivamente reduzido.

Computação neuromórfica

Alternativamente, é um exercício interessante para comparar o uso de energia no cérebro humano. O cérebro é frequentemente aclamado como sendo muito eficiente em termos de energia, Usando apenas alguns watts – Muito menos que os modelos de IA – para operações como respirar ou pensar.

No entanto, não parece ser os elementos físicos básicos do cérebro que economizam energia. O disparo de uma sinapse, que pode ser comparado a uma única etapa computacional, na verdade usa a mesma quantidade de energia que um transistor requer por bit.

No entanto, a arquitetura do cérebro é altamente interconectada e trabalha fundamentalmente de maneira diferente dos processadores eletrônicos e dos biocomputadores baseados em rede. O chamado computação neuromórfica Tentativas de imitar esse aspecto das operações cerebrais, mas usando novos tipos de hardware de computador, em oposição à biocomputa.

Seria muito interessante comparar as arquiteturas neuromórficas com o limite de Landauer para verificar se os mesmos tipos de idéias da biocomputa poderiam ser transferíveis para aqui no futuro. Nesse caso, ele também poderia manter a chave para um grande salto adiante na eficiência energética do computador nos próximos anos.

Este artigo editado é republicado de A conversa sob uma licença Creative Commons. Leia o Artigo original.